VI. Comprendre EXPLAIN▲

VI-A. Introduction▲

- Le matériel, le système et la configuration sont importants pour les performances.

- Mais il est aussi essentiel de se préoccuper des requêtes et de leurs performances.

Face à un problème de performances, l’administrateur se retrouve assez rapidement face à une (ou plusieurs) requête(s). Une requête en soi représente très peu d’informations. Suivant la requête, des dizaines de plans peuvent être sélectionnés pour l’exécuter. Il est donc nécessaire de pouvoir trouver le plan d’exécution et de comprendre ce plan. Cela permet de mieux appréhender la requête et de mieux comprendre les pistes envisageables pour la corriger.

VI-A-1. Au menu▲

- Exécution globale d’une requête.

- Planificateur : utilité, statistiques et configuration.

- EXPLAIN.

- Nœuds d’un plan.

- Outils.

Avant de détailler le fonctionnement du planificateur, nous allons regarder la façon dont une requête s’exécute globalement. Ensuite, nous aborderons le planificateur : en quoi est-il utile, comment fonctionne-t-il, et comment le configurer ? Nous ferons un tour sur le fonctionnement de la commande EXPLAIN et les informations qu’elle fournit. Nous verrons aussi l’ensemble des opérations utilisables par le planificateur. Enfin, nous listerons les outils essentiels pour faciliter la compréhension d’un plan de requête.

VI-A-2. Jeu de tests▲

-

Tables :

- services, contenant 4 lignes,

- services_big, contenant environ 40k lignes,

- employes, contenant 14 lignes,

- employes_big, contenant environ 500k lignes.

-

Index :

- sur la colonne num_service, via la clé primaire des tables services et services_big,

- sur la colonne matricule, via la clé primaire des tables employes et employes_big,

- sur la colonne date_embauche pour employes,

- sur la colonne num_service pour employes_big.

Le script suivant permet de recréer le jeu d’essai :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

22.

23.

24.

25.

26.

27.

28.

29.

30.

31.

32.

33.

34.

35.

36.

37.

38.

39.

40.

41.

42.

43.

44.

45.

46.

47.

48.

49.

50.

51.

52.

53.

54.

55.

56.

57.

58.

59.

60.

61.

62.

63.

64.

65.

66.

67.

68.

69.

70.

71.

72.

73.

74.

75.

76.

77.

78.

79.

80.

81.

82.

83.

84.

85.

86.

87.

88.

89.

90.

91.

92.

93.

94.

95.

-- suppression des tables si elles existent

DROP TABLE IF EXISTS services CASCADE;

DROP TABLE IF EXISTS services_big CASCADE;

DROP TABLE IF EXISTS employes CASCADE;

DROP TABLE IF EXISTS employes_big CASCADE;

-- définition des tables

CREATE TABLE services (

num_service serial PRIMARY KEY,

nom_service character varying(20),

localisation character varying(20),

departement integer,

date_creation date

);

CREATE TABLE services_big (

num_service serial PRIMARY KEY,

nom_service character varying(20),

localisation character varying(20),

departement integer,

date_creation date

);

CREATE TABLE employes (

matricule serial primary key,

nom varchar(15) not null,

prenom varchar(15) not null,

fonction varchar(20) not null,

manager integer,

date_embauche date,

num_service integer not null references services (num_service)

);

CREATE TABLE employes_big (

matricule serial primary key,

nom varchar(15) not null,

prenom varchar(15) not null,

fonction varchar(20) not null,

manager integer,

date_embauche date,

num_service integer not null references services (num_service)

);

-- ajout des données

INSERT INTO services

VALUES

(1, 'Comptabilité', 'Paris', 75, '2006-09-03'),

(2, 'R&D', 'Rennes', 40, '2009-08-03'),

(3, 'Commerciaux', 'Limoges', 52, '2006-09-03'),

(4, 'Consultants', 'Nantes', 44, '2009-08-03');

INSERT INTO services_big (nom_service, localisation, departement, date_creation)

VALUES

('Comptabilité', 'Paris', 75, '2006-09-03'),

('R&D', 'Rennes', 40, '2009-08-03'),

('Commerciaux', 'Limoges', 52, '2006-09-03'),

('Consultants', 'Nantes', 44, '2009-08-03');

INSERT INTO services_big (nom_service, localisation, departement, date_creation)

SELECT s.nom_service, s.localisation, s.departement, s.date_creation

FROM services s, generate_series(1, 10000);

INSERT INTO employes VALUES

(33, 'Roy', 'Arthur', 'Consultant', 105, '2000-06-01', 4),

(81, 'Prunelle', 'Léon', 'Commercial', 97, '2000-06-01', 3),

(97, 'Lebowski', 'Dude', 'Responsable', 104, '2003-01-01', 3),

(104, 'Cruchot', 'Ludovic', 'Directeur Général', NULL, '2005-03-06', 3),

(105, 'Vacuum', 'Anne-Lise', 'Responsable', 104, '2005-03-06', 4),

(119, 'Thierrie', 'Armand', 'Consultant', 105, '2006-01-01', 4),

(120, 'Tricard', 'Gaston', 'Développeur', 125, '2006-01-01', 2),

(125, 'Berlicot', 'Jules', 'Responsable', 104, '2006-03-01', 2),

(126, 'Fougasse', 'Lucien', 'Comptable', 128, '2006-03-01', 1),

(128, 'Cruchot', 'Josépha', 'Responsable', 105, '2006-03-01', 1),

(131, 'Lareine-Leroy', 'Émilie', 'Développeur', 125, '2006-06-01', 2),

(135, 'Brisebard', 'Sylvie', 'Commercial', 97, '2006-09-01', 3),

(136, 'Barnier', 'Germaine', 'Consultant', 105, '2006-09-01', 4),

(137, 'Pivert', 'Victor', 'Consultant', 105, '2006-09-01', 4);

INSERT INTO employes_big SELECT * FROM employes;

INSERT INTO employes_big

SELECT i, nom,prenom,fonction,manager,date_embauche,num_service

FROM employes_big,

LATERAL generate_series(1000, 500000) i

WHERE matricule=137;

-- création des index

CREATE INDEX ON employes(date_embauche);

CREATE INDEX ON employes_big(date_embauche);

CREATE INDEX ON employes_big(num_service);

-- calcul des statistiques sur les nouvelles données

VACUUM ANALYZE;

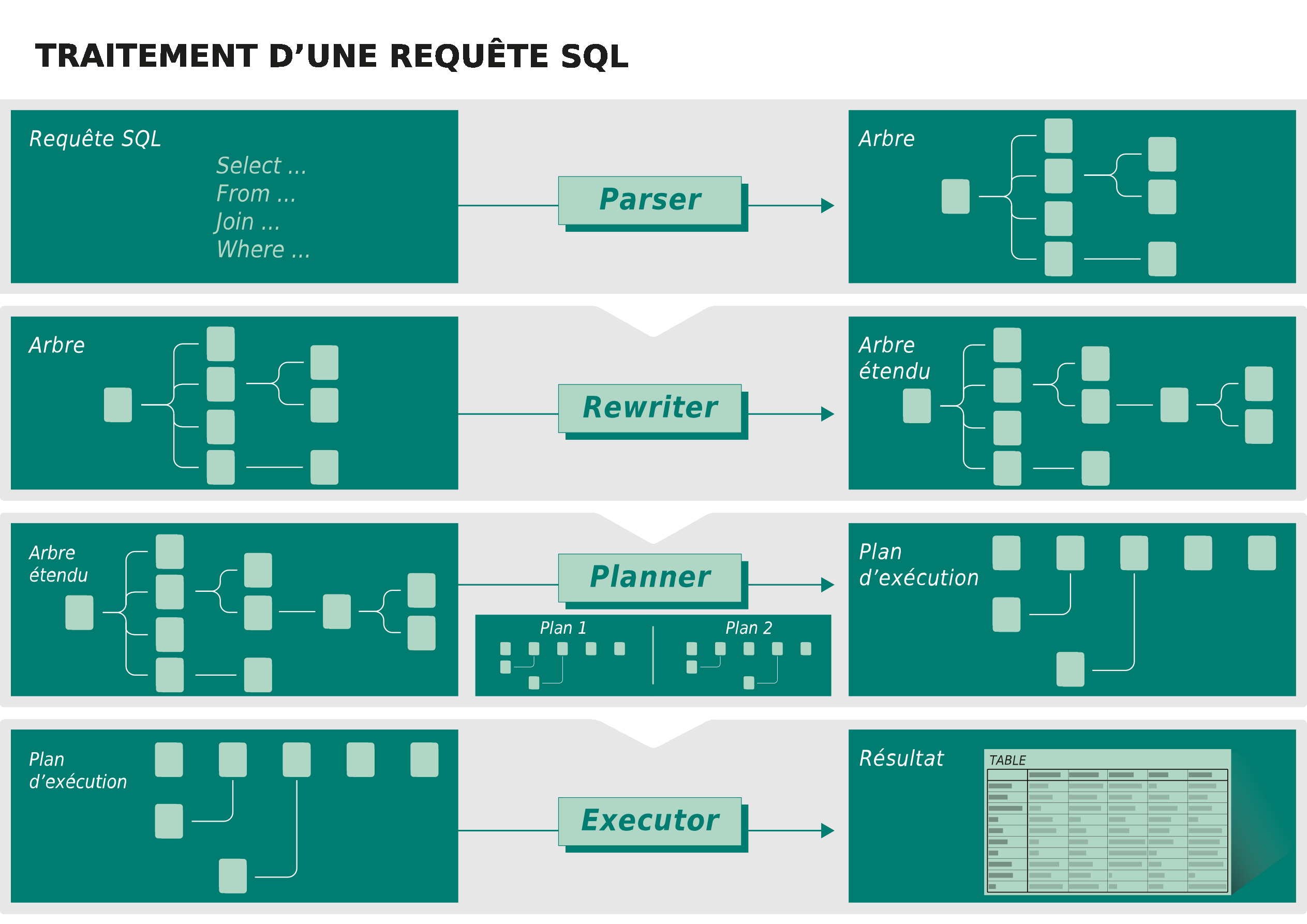

VI-B. Exécution globale d’une requête▲

-

L’exécution peut se voir sur deux niveaux :

- niveau système,

- niveau SGBD.

- De toute façon, composée de plusieurs étapes.

L’exécution d’une requête peut se voir sur deux niveaux :

- ce que le système perçoit ;

- ce que le SGBD fait.

Dans les deux cas, cela va nous permettre de trouver les possibilités de lenteurs dans l’exécution d’une requête par un utilisateur.

VI-B-1. Niveau système▲

- Le client envoie une requête au serveur de bases de données.

- Le serveur l’exécute.

- Puis il renvoie le résultat au client.

PostgreSQL est un système client-serveur. L’utilisateur se connecte via un outil (le client) à une base d’une instance PostgreSQL (le serveur). L’outil peut envoyer une requête au serveur, celui-ci l’exécute et finit par renvoyer les données résultant de la requête ou le statut de la requête.

Généralement, l’envoi de la requête est rapide. Par contre, la récupération des données peut poser problème si une grosse volumétrie est demandée sur un réseau à faible débit. L’affichage peut aussi être un problème (afficher une ligne sera plus rapide qu’afficher un million de lignes, afficher un entier est plus rapide qu’afficher un document texte de 1 Mo, etc.).

VI-B-2. Niveau SGBD▲

Lorsque le serveur récupère la requête, un ensemble de traitements est réalisé :

- le parser va réaliser une analyse syntaxique de la requête ;

- le rewriter va réécrire, si nécessaire la requête ;

- pour cela, il prend en compte les règles, les vues non matérialisées et les fonctions SQL ;

- si une règle demande de changer la requête, la requête envoyée est remplacée par la nouvelle ;

- si une vue non matérialisée est utilisée, la requête qu’elle contient est intégrée dans la requête envoyée ;

- si une fonction SQL intégrable est utilisée, la requête qu’elle contient est intégrée dans la requête envoyée ;

- le planner va générer l’ensemble des plans d’exécutions ;

- il calcule le coût de chaque plan ;

- puis il choisit le plan le moins coûteux, donc le plus intéressant ;

- l’ executer exécute la requête ;

- pour cela, il doit commencer par récupérer les verrous nécessaires sur les objets ciblés ;

- une fois les verrous récupérés, il exécute la requête ;

- une fois la requête exécutée, il envoie les résultats à l’utilisateur.

Plusieurs goulets d’étranglement sont visibles ici. Les plus importants sont :

- la planification (à tel point qu’il est parfois préférable de ne générer qu’un sous-ensemble de plans, pour passer plus rapidement à la phase d’exécution) ;

- la récupération des verrous (une requête peut attendre plusieurs secondes, minutes, voire heures, avant de récupérer les verrous et exécuter réellement la requête) ;

- l’exécution de la requête ;

- l’envoi des résultats à l’utilisateur.

Il est possible de tracer l’exécution des différentes étapes grâce aux options log_parser_stats, log_planner_stats et log_executor_stats. Voici un exemple complet :

- Mise en place de la configuration sur la session :

2.

3.

4.

SET log_parser_stats TO on;

SET log_planner_stats TO on;

SET log_executor_stats TO on;

SET client_min_messages TO log;

- Exécution de la requête :

SELECTfonction,count(*)FROMemployes_bigORDERBYfonction;- Trace du parser

LOG: PARSER STATISTICS

DETAIL: ! system usage stats:

! 0.000015 s user, 0.000000 s system, 0.000015 s elapsed

! [5.191712 s user, 0.241927 s system total]

! 0/0 [0/470824] filesystem blocks in/out

! 0/0 [0/34363] page faults/reclaims, 0 [0] swaps

! 0 [0] signals rcvd, 0/0 [0/0] messages rcvd/sent

! 0/0 [1143/170] voluntary/involuntary context switches

LOG: PARSE ANALYSIS STATISTICS

DETAIL: ! system usage stats:

! 0.000183 s user, 0.000000 s system, 0.000189 s elapsed

! [5.191915 s user, 0.241928 s system total]

! 0/0 [0/470824] filesystem blocks in/out

! 0/12 [0/34375] page faults/reclaims, 0 [0] swaps

! 0 [0] signals rcvd, 0/0 [0/0] messages rcvd/sent

! 0/0 [1143/170] voluntary/involuntary context switches- Trace du rewriter

LOG: REWRITER STATISTICS

DETAIL: ! system usage stats:

! 0.000004 s user, 0.000000 s system, 0.000004 s elapsed

! [5.191940 s user, 0.241928 s system total]

! 0/0 [0/470824] filesystem blocks in/out

! 0/0 [0/34375] page faults/reclaims, 0 [0] swaps

! 0 [0] signals rcvd, 0/0 [0/0] messages rcvd/sent

! 0/0 [1143/170] voluntary/involuntary context switches- Trace du planner

LOG: PLANNER STATISTICS

DETAIL: ! system usage stats:

! 0.000159 s user, 0.000000 s system, 0.000159 s elapsed

! [5.192119 s user, 0.241928 s system total]

! 0/0 [0/470824] filesystem blocks in/out

! 0/8 [0/34383] page faults/reclaims, 0 [0] swaps

! 0 [0] signals rcvd, 0/0 [0/0] messages rcvd/sent

! 0/0 [1143/170] voluntary/involuntary context switches- Trace de l’ executer

LOG: EXECUTOR STATISTICS

DETAIL: ! system usage stats:

! 0.078269 s user, 0.000000 s system, 0.093096 s elapsed

! [5.270446 s user, 0.241928 s system total]

! 0/0 [0/470824] filesystem blocks in/out

! 0/9 [0/34392] page faults/reclaims, 0 [0] swaps

! 0 [0] signals rcvd, 0/0 [0/0] messages rcvd/sent

! 2/68 [1145/240] voluntary/involuntary context switchesVI-B-3. Exceptions▲

- Requêtes DDL.

- Instructions TRUNCATE et COPY.

-

Pas de réécriture, pas de plans d’exécution… :

- une exécution directe.

Il existe quelques requêtes qui échappent à la séquence d’opérations présentées précédemment. Toutes les opérations DDL (modification de la structure de la base), les instructions TRUNCATE et COPY (en partie) sont vérifiées syntaxiquement, puis directement exécutées. Les étapes de réécriture et de planification ne sont pas réalisées.

Le principal souci pour les performances sur ce type d’instructions est donc l’obtention des verrous et l’exécution réelle.

VI-C. Quelques définitions▲

-

Prédicat :

- filtre de la clause WHERE.

-

Sélectivité :

- pourcentage de lignes retournées après application d’un prédicat.

-

Cardinalité :

- nombre de lignes d’une table,

- nombre de lignes retournées après filtrage.

Un prédicat est une condition de filtrage présente dans la clause WHERE d’une requête. Par exemple colonne = valeur.

La sélectivité est liée à l’application d’un prédicat sur une table. Elle détermine le nombre de lignes remontées par la lecture d’une relation suite à l’application d’une clause de filtrage, ou prédicat. Elle peut être vue comme un coefficient de filtrage d’un prédicat. La sélectivité est exprimée sous la forme d’un pourcentage. Pour une table de 1000 lignes, si la sélectivité d’un prédicat est de 10 %, la lecture de la table en appliquant le prédicat devrait retourner 10 % des lignes, soit 100 lignes.

La cardinalité représente le nombre de lignes d’une relation. En d’autres termes, la cardinalité représente le nombre de lignes d’une table ou du résultat d’une fonction. Elle représente aussi le nombre de lignes retournées par la lecture d’une table après application d’un ou plusieurs prédicats.

VI-C-1. Requête étudiée▲

2.

3.

4.

SELECT matricule, nom, prenom, nom_service, fonction, localisation

FROM employes emp

JOIN services ser ON (emp.num_service = ser.num_service)

WHERE ser.localisation = 'Nantes';

Cette requête permet de déterminer les employés basés à Nantes.

VI-C-2. Plan de la requête étudiée▲

L’objet de ce module est de comprendre son plan d’exécution :

2.

3.

4.

5.

Nested Loop (cost=0.00..2.37 rows=4 width=48)

Join Filter: (emp.num_service = ser.num_service)

-> Seq Scan on services ser (cost=0.00..1.05 rows=1 width=21)

Filter: ((localisation)::text = 'Nantes'::text)

-> Seq Scan on employes emp (cost=0.00..1.14 rows=14 width=35)

La directive EXPLAIN permet de connaître le plan d’exécution d’une requête. Elle permet de savoir par quelles étapes va passer le SGBD pour répondre à la requête.

Ce plan montre une jointure par Nested Loop. Pour faciliter la compréhension, un autre plan utilisant une jointure par hachage sera utilisé et étudié ultérieurement.

VI-D. Planificateur▲

- Chargé de sélectionner le meilleur plan d’exécution.

-

Énumère tous les plans d’exécution :

- tous ou presque…

- Calcule leur coût suivant des statistiques, un peu de configuration et beaucoup de règles.

- Sélectionne le meilleur (le moins coûteux).

Le but du planificateur est assez simple. Pour une requête, il existe de nombreux plans d’exécution possibles. Il va donc énumérer tous les plans d’exécution possibles (sauf si cela représente vraiment trop de plans, auquel cas il ne prendra en compte qu’une partie des plans possibles). Lors de cette énumération des différents plans, il calcule leur coût. Cela lui permet d’en ignorer certains alors qu’ils sont incomplets si leur plan d’exécution est déjà plus coûteux que les autres. Pour calculer le coût, il dispose d’informations sur les données (des statistiques), d’une configuration (réalisée par l’administrateur de bases de données) et d’un ensemble de règles inscrites en dur. À la fin de l’énumération et du calcul de coût, il ne lui reste plus qu’à sélectionner le plan qui a le plus petit coût.

VI-D-1. Utilité▲

- SQL est un langage déclaratif.

-

Une requête décrit le résultat à obtenir :

- mais pas la façon de l’obtenir.

- C’est au planificateur de déduire le moyen de parvenir au résultat demandé.

Le planificateur est un composant essentiel d’un moteur de bases de données. Les moteurs utilisent un langage SQL qui permet à l’utilisateur de décrire le résultat qu’il souhaite obtenir. Par exemple, s’il veut récupérer des informations sur tous les clients dont le nom commence par la lettre A en triant les clients par leur département, il pourrait utiliser une requête du type :

SELECT * FROM employes WHERE nom LIKE 'A%' ORDER BY num_service;

Un moteur de bases de données peut récupérer les données de plusieurs façons :

- faire un parcours séquentiel de la table employes en filtrant les enregistrements d’après leur nom, puis trier les données grâce à un algorithme ;

- faire un parcours d’index sur la colonne nom pour trouver plus rapidement les enregistrements de la table clients satisfaisant le filtre 'A%', puis trier les données grâce à un algorithme ;

- faire un parcours d’index sur la colonne num_service pour récupérer les enregistrements déjà triés, et ne retourner que ceux vérifiant le prédicat nom like 'A%'.

Et ce ne sont que quelques exemples, car il serait possible d’avoir un index utilisable pour le tri et le filtre par exemple.

Donc la requête décrit le résultat à obtenir, et le planificateur va chercher le meilleur moyen pour parvenir à ce résultat.

Pour ce travail, il dispose d’un certain nombre d’opérations de base. Ces opérations travaillent sur des ensembles de lignes, généralement un ou deux. Chaque opération renvoie un seul ensemble de lignes. Le planificateur peut combiner ces opérations suivant certaines règles. Une opération peut renvoyer l’ensemble de résultats de deux façons : d’un coup (par exemple le tri) ou petit à petit (par exemple un parcours séquentiel). Le premier cas utilise plus de mémoire, et peut nécessiter d’écrire des données temporaires sur disque. Le deuxième cas aide à accélérer des opérations comme les curseurs, les sous-requêtes IN et EXISTS, la clause LIMIT, etc.

VI-D-2. Règles▲

- 1re règle : Récupérer le bon résultat.

-

2e règle : Le plus rapidement possible :

- en minimisant les opérations disques,

- en préférant les lectures séquentielles,

- en minimisant la charge CPU,

- en minimisant l’utilisation de la mémoire.

Le planificateur suit deux règles :

- il doit récupérer le bon résultat ;

- il doit le récupérer le plus rapidement possible.

Cette deuxième règle lui impose de minimiser l’utilisation des ressources : en tout premier lieu les opérations disques vu qu’elles sont les plus coûteuses, mais aussi la charge CPU (charge des CPU utilisés et nombre de CPU utilisés) et l’utilisation de la mémoire. Dans le cas des opérations disques, s’il doit en faire, il doit absolument privilégier les opérations séquentielles aux opérations aléatoires (qui demandent un déplacement de la tête de disque, ce qui est l’opération la plus coûteuse sur les disques magnétiques).

VI-D-3. Outils de l’optimiseur▲

-

L’optimiseur s’appuie sur :

- un mécanisme de calcul de coûts,

- des statistiques sur les données,

- le schéma de la base de données.

Pour déterminer le chemin d’exécution le moins coûteux, l’optimiseur devrait connaître précisément les données mises en œuvre dans la requête, les particularités du matériel et la charge en cours sur ce matériel. Cela est impossible. Ce problème est contourné en utilisant deux mécanismes liés l’un à l’autre :

- un mécanisme de calcul de coût de chaque opération ;

- des statistiques sur les données.

Pour quantifier la charge nécessaire pour répondre à une requête, PostgreSQL utilise un mécanisme de coût. Il part du principe que chaque opération a un coût plus ou moins important. Les statistiques sur les données permettent à l’optimiseur de requêtes de déterminer assez précisément la répartition des valeurs d’une colonne d’une table, sous la forme d’histogramme. Il dispose encore d’autres informations comme la répartition des valeurs les plus fréquentes, le pourcentage de NULL, le nombre de valeurs distinctes, etc. Toutes ces informations aideront l’optimiseur à déterminer la sélectivité d’un filtre (prédicat de la clause WHERE, condition de jointure) et donc la quantité de données récupérées par la lecture d’une table en utilisant le filtre évalué. Enfin, l’optimiseur s’appuie sur le schéma de la base de données afin de déterminer différents paramètres qui entrent dans le calcul du plan d’exécution : contrainte d’unicité sur une colonne, présence d’une contrainte NOT NULL, etc.

VI-D-4. Optimisations▲

-

À partir du modèle de données :

- suppression de jointures externes inutiles.

-

Transformation des sous-requêtes :

- certaines sous-requêtes transformées en jointures.

-

Appliquer les prédicats le plus tôt possible :

- réduit le jeu de données manipulé.

-

Intègre le code des fonctions SQL simples (inline) :

- évite un appel de fonction coûteux.

Suppression des jointures externes inutiles

À partir du modèle de données et de la requête soumise, l’optimiseur de PostgreSQL va pouvoir déterminer si une jointure externe n’est pas utile à la production du résultat.

Sous certaines conditions, PostgreSQL peut supprimer des jointures externes, à condition que le résultat ne soit pas modifié :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

EXPLAIN

SELECT e.matricule, e.nom, e.prenom

FROM employes e

LEFT JOIN services s

ON (e.num_service = s.num_service)

WHERE e.num_service = 4;

QUERY PLAN

-----------------------------------------------------------

Seq Scan on employes e (cost=0.00..1.18 rows=5 width=19)

Filter: (num_service = 4)

(2 rows)

Toutefois, si le prédicat de la requête est modifié pour s’appliquer sur la table services, la jointure est tout de même réalisée, puisqu’on réalise un test d’existence sur cette table services :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

EXPLAIN

SELECT e.matricule, e.nom, e.prenom

FROM employes e

LEFT JOIN services s

ON (e.num_service = s.num_service)

WHERE s.num_service = 4;

QUERY PLAN

-----------------------------------------------------------------

Nested Loop (cost=0.00..2.27 rows=5 width=19)

-> Seq Scan on services s (cost=0.00..1.05 rows=1 width=4)

Filter: (num_service = 4)

-> Seq Scan on employes e (cost=0.00..1.18 rows=5 width=23)

Filter: (num_service = 4)

(5 rows)

Transformation des sous-requêtes

Certaines sous-requêtes sont transformées en jointure :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

EXPLAIN

SELECT *

FROM employes emp

JOIN (SELECT * FROM services WHERE num_service = 1) ser

ON (emp.num_service = ser.num_service);

QUERY PLAN

-------------------------------------------------------------------

Nested Loop (cost=0.00..2.25 rows=2 width=64)

-> Seq Scan on services (cost=0.00..1.05 rows=1 width=21)

Filter: (num_service = 1)

-> Seq Scan on employes emp (cost=0.00..1.18 rows=2 width=43)

Filter: (num_service = 1)

(5 rows)

La sous-requête ser a été remontée dans l’arbre de requête pour être intégré en jointure.

Application des prédicats au plus tôt

Lorsque cela est possible, PostgreSQL essaye d’appliquer les prédicats au plus tôt :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

EXPLAIN

SELECT MAX(date_embauche)

FROM (SELECT * FROM employes WHERE num_service = 4) e

WHERE e.date_embauche < '2006-01-01';

QUERY PLAN

------------------------------------------------------------------------------

Aggregate (cost=1.21..1.22 rows=1 width=4)

-> Seq Scan on employes (cost=0.00..1.21 rows=2 width=4)

Filter: ((date_embauche < '2006-01-01'::date) AND (num_service = 4))

(3 rows)

Les deux prédicats num_service = 4 et date_embauche < '2006-01-01' ont été appliqués en même temps, réduisant ainsi le jeu de données à considérer dès le départ.

En cas de problème, il est possible d’utiliser une CTE (clause WITH) pour bloquer cette optimisation :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

EXPLAIN

WITH e AS (SELECT * FROM employes WHERE num_service = 4)

SELECT MAX(date_embauche)

FROM e

WHERE e.date_embauche < '2006-01-01';

QUERY PLAN

-----------------------------------------------------------------

Aggregate (cost=1.29..1.30 rows=1 width=4)

CTE e

-> Seq Scan on employes (cost=0.00..1.18 rows=5 width=43)

Filter: (num_service = 4)

-> CTE Scan on e (cost=0.00..0.11 rows=2 width=4)

Filter: (date_embauche < '2006-01-01'::date)

(6 rows)

Function inlining

Voici deux fonctions, la première écrite en SQL, la seconde en PL/pgsql :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

CREATE OR REPLACE FUNCTION add_months_sql(mydate date, nbrmonth integer)

RETURNS date AS

$BODY$

SELECT ( mydate + interval '1 month' * nbrmonth )::date;

$BODY$

LANGUAGE SQL;

CREATE OR REPLACE FUNCTION add_months_plpgsql(mydate date, nbrmonth integer)

RETURNS date AS

$BODY$

BEGIN RETURN ( mydate + interval '1 month' * nbrmonth ); END;

$BODY$

LANGUAGE plpgsql;

Si l’on utilise la fonction écrite en PL/pgsql, on retrouve l’appel de la fonction dans la clause Filter du plan d’exécution de la requête :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

EXPLAIN (ANALYZE, BUFFERS, COSTS off)

SELECT *

FROM employes

WHERE date_embauche = add_months_plpgsql(now()::date, -1);

QUERY PLAN

------------------------------------------------------------------------------

Seq Scan on employes (actual time=0.098..0.098 rows=0 loops=1)

Filter: (date_embauche = add_months_plpgsql((now())::date, '-1'::integer))

Rows Removed by Filter: 14

Buffers: shared hit=1

Planning time: 0.052 ms

Execution time: 0.133 ms

(6 rows)

PostgreSQL ne sait pas intégrer le code des fonctions PL/pgsql dans ses plans d’exécution.

En revanche, en utilisant la fonction écrite en langage SQL, la définition de la fonction a été intégrée dans la clause de filtrage de la requête :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

EXPLAIN (ANALYZE, BUFFERS, COSTS off)

SELECT *

FROM employes

WHERE date_embauche = add_months_sql(now()::date, -1);

QUERY PLAN

---------------------------------------------------------------------------

Seq Scan on employes (actual time=0.009..0.009 rows=0 loops=1)

Filter: (date_embauche = (((now())::date + '-1 mons'::interval))::date)

Rows Removed by Filter: 14

Buffers: shared hit=1

Planning time: 0.088 ms

Execution time: 0.018 ms

(6 rows)

Le code de la fonction SQL a été correctement intégré dans le plan d’exécution. Le temps d’exécution a été divisé par deux sur ce jeu de données très réduit, montrant l’impact de l’appel d’une fonction dans une clause de filtrage. Le changement serait encore plus flagrant avec un index sur la colonne date_embauche, étant donné que l’utilisation de la fonction PL/pgsql empêcherait son utilisation, contrairement à celle écrite en SQL :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

22.

23.

24.

25.

26.

27.

28.

29.

EXPLAIN (ANALYZE, BUFFERS, COSTS off)

SELECT *

FROM employes_big

WHERE date_embauche = add_months_plpgsql(now()::date, -1);

QUERY PLAN

------------------------------------------------------------------------------

Seq Scan on employes_big (actual time=576.848..576.848 rows=0 loops=1)

Filter: (date_embauche = add_months_plpgsql((now())::date, '-1'::integer))

Rows Removed by Filter: 499015

Buffers: shared hit=4664

Planning time: 0.073 ms

Execution time: 576.860 ms

(6 rows)

EXPLAIN (ANALYZE, BUFFERS, COSTS off)

SELECT *

FROM employes_big

WHERE date_embauche = add_months_sql(now()::date, -1);

QUERY PLAN

-------------------------------------------------------------------------------

Index Scan using employes_big_date_embauche_idx on employes_big

(actual time=0.036..0.036 rows=0 loops=1)

Index Cond: (date_embauche = (((now())::date + '-1 mons'::interval))::date)

Buffers: shared read=3

Planning time: 0.093 ms

Execution time: 0.048 ms

(5 rows)

Cette fois, l’exécution est beaucoup plus rapide !

VI-D-5. Décisions▲

-

Stratégie d’accès aux lignes :

- par parcours d’une table, d’un index, de TID, etc.

-

Stratégie d’utilisation des jointures :

- ordre des jointures,

- type de jointure (Nested Loop, Merge/Sort Join, Hash Join),

- ordre des tables jointes dans une même jointure.

-

Stratégie d’agrégation :

- brut, trié, haché.

Pour exécuter une requête, le planificateur va utiliser des opérations. Pour lire des lignes, il peut utiliser un parcours de table, un parcours d’index ou encore d’autres types de parcours. Ce sont généralement les premières opérations utilisées. Ensuite, d’autres opérations permettent différentes actions :

- joindre deux ensembles de lignes avec des opérations de jointure (trois au total) ;

- agréger un ensemble de lignes avec une opération d’agrégation (trois là aussi) ;

- trier un ensemble de lignes ;

- etc.

VI-D-6. Parallélisation▲

-

Disponible depuis la version 9.6 :

- parcours séquentiel,

- jointures Nested Loop et Hash Join,

- agrégats.

-

Améliorée en version 10 :

- parcours d’index (Btree uniquement),

- jointures Merge Join.

-

Des limitations :

- pas sur les écritures,

- pas en cas de verrous,

- pas sur les opérations DDL,

- pas sur les curseurs.

La parallélisation de l’exécution d’une requête est disponible depuis la version 9.6 de PostgreSQL. Elle est désactivée par défaut sur cette version, mais l’implémentation permet de paralléliser les parcours de table (SeqScan), les jointures (Nested Loop et Hash Join), ainsi que certaines fonctions d’agrégat (comme min, max, avg, sum, etc.).

La version 10 améliore cette implémentation en proposant de paralléliser les parcours d’index (Index Scan, Index Only Scan et Bitmap Scan). Seuls les index B-tree utilisent cette nouvelle API pour l’instant. Il est aussi possible de paralléliser les jointures de type Merge Join.

Même si cette fonctionnalité évolue bien, des limitations assez fortes restent présentes, notamment :

- pas de parallélisation pour les écritures de données (INSERT, UPDATE, DELETE, etc.),

- pas de parallélisation sur les opérations DDL (par exemple un CREATE INDEX ou un VACUUM ne peuvent pas être parallélisés).

VI-E. Mécanisme de coûts▲

-

Modèle basé sur les coûts :

- quantifier la charge pour répondre à une requête.

-

Chaque opération a un coût :

- lire un bloc selon sa position sur le disque,

- manipuler une ligne issue d’une lecture de table ou d’index,

- appliquer un opérateur.

L’optimiseur statistique de PostgreSQL utilise un modèle de calcul de coût. Les coûts calculés sont des indications arbitraires sur la charge nécessaire pour répondre à une requête. Chaque facteur de coût représente une unité de travail : lecture d’un bloc, manipulation des lignes en mémoire, application d’un opérateur sur des données.

VI-E-1. Coûts unitaires▲

-

L’optimiseur a besoin de connaître :

- le coût relatif d’un accès séquentiel au disque,

- le coût relatif d’un accès aléatoire au disque,

- le coût relatif de la manipulation d’une ligne en mémoire,

- le coût de traitement d’une donnée issue d’un index,

- le coût d’application d’un opérateur,

- le coût de la manipulation d’une ligne en mémoire pour un parcours parallélisé,

- le coût de mise en place d’un parcours parallélisé.

- Paramètres modifiables dynamiquement avec SET.

Pour quantifier la charge nécessaire pour répondre à une requête, PostgreSQL utilise un mécanisme de coût. Il part du principe que chaque opération a un coût plus ou moins important.

Sept paramètres permettent d’ajuster les coûts relatifs :

- seq_page_cost représente le coût relatif d’un accès séquentiel au disque. Ce paramètre vaut 1 par défaut.

- random_page_cost représente le coût relatif d’un accès aléatoire au disque. Ce paramètre vaut 4 par défaut, cela signifie que le temps de déplacement de la tête de lecture de façon aléatoire est estimé quatre fois plus important que le temps d’accès d’un bloc au suivant.

- cpu_tuple_cost représente le coût relatif de la manipulation d’une ligne en mémoire. Ce paramètre vaut par défaut 0,01.

- cpu_index_tuple_cost répercute le coût de traitement d’une donnée issue d’un index. Ce paramètre vaut par défaut 0,005.

- cpu_operator_cost indique le coût d’application d’un opérateur sur une donnée. Ce paramètre vaut par défaut 0,0025.

- parallel_tuple_cost indique le coût de traitement d’une ligne lors d’un parcours parallélisé. Ce paramètre vaut par défaut 0,1.

- parallel_setup_cost indique le coût de mise en place d’un parcours parallélisé. Ce paramètre vaut par défaut 1000.

En général, on ne modifie pas ces paramètres sans justification sérieuse. On peut être amené à diminuer random_page_cost si le serveur dispose de disques rapides et d’une carte RAID équipée d’un cache important. Mais en faisant cela, il faut veiller à ne pas déstabiliser des plans optimaux qui obtiennent des temps de réponse constants. À trop diminuer random_page_cost, on peut obtenir de meilleurs temps de réponse si les données sont en cache, mais aussi des temps de réponse dégradés si les données ne sont pas en cache.

Pour des besoins particuliers, ces paramètres sont des paramètres de sessions. Ils peuvent être modifiés dynamiquement avec l’ordre SET au niveau de l’application en vue d’exécuter des requêtes bien particulières.

VI-F. Statistiques▲

-

Toutes les décisions du planificateur se basent sur les statistiques :

- le choix du parcours,

- comme le choix des jointures.

- Statistiques mises à jour avec ANALYZE.

- Sans bonnes statistiques, pas de bons plans.

Le planificateur se base principalement sur les statistiques pour ses décisions. Le choix du parcours, le choix des jointures, le choix de l’ordre des jointures, tout cela dépend des statistiques (et un peu de la configuration). Sans statistiques à jour, le choix du planificateur a un fort risque d’être mauvais. Il est donc important que les statistiques soient mises à jour fréquemment. La mise à jour se fait avec l’instruction ANALYZE qui peut être exécutée manuellement ou automatiquement (via un cron ou l’autovacuum par exemple).

VI-F-1. Utilisation des statistiques▲

-

L’optimiseur utilise les statistiques pour déterminer :

- la cardinalité d’un filtre -> quelle stratégie d’accès,

- la cardinalité d’une jointure -> quel algorithme de jointure,

- la cardinalité d’un regroupement -> quel algorithme de regroupement.

Les statistiques sur les données permettent à l’optimiseur de requêtes de déterminer assez précisément la répartition des valeurs d’une colonne d’une table, sous la forme d’un histogramme de répartition des valeurs. Il dispose encore d’autres informations comme la répartition des valeurs les plus fréquentes, le pourcentage de NULL, le nombre de valeurs distinctes, etc. Toutes ces informations aideront l’optimiseur à déterminer la sélectivité d’un filtre (prédicat de la clause WHERE, condition de jointure) et donc quelle sera la quantité de données récupérées par la lecture d’une table en utilisant le filtre évalué.

Grâce aux statistiques connues par PostgreSQL (voir la vue pg_stats), l’optimiseur est capable de déterminer le chemin le plus intéressant selon les valeurs recherchées.

Ainsi, avec un filtre peu sélectif, date_embauche = '2006-09-01', la requête va ramener pratiquement l’intégralité de la table. PostgreSQL choisira donc une lecture séquentielle de la table, ou Seq Scan :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

EXPLAIN (ANALYZE, TIMING OFF)

SELECT * FROM employes_big WHERE date_embauche='2006-09-01';

QUERY PLAN

----------------------------------------------------------------------

Seq Scan on employes_big (cost=0.00..10901.69 rows=498998 width=40)

(actual rows=499004 loops=1)

Filter: (date_embauche = '2006-09-01'::date)

Rows Removed by Filter: 11

Planning time: 0.027 ms

Execution time: 42.624 ms

(5 rows)

La partie cost montre que l’optimiseur estime que la lecture va ramener 498 998 lignes. Comme on peut le voir, ce n’est pas exact. Il va en récupérer 499 004. Ce n’est qu’une estimation basée sur des statistiques selon la répartition des données et ces estimations seront la plupart du temps erronées. L’important est de savoir si l’erreur est négligeable ou si elle est importante. Dans notre cas, elle est négligeable.

Avec un filtre plus sélectif, la requête ne ramènera que deux lignes. L’optimiseur préférera donc passer par l’index que l’on a créé :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

EXPLAIN (ANALYZE, TIMING OFF)

SELECT * FROM employes_big WHERE date_embauche='2006-01-01';

QUERY PLAN

-----------------------------------------------------------------

Index Scan using employes_big_date_embauche_idx on employes_big

(cost=0.42..8.72 rows=17 width=40) (actual rows=2 loops=1)

Index Cond: (date_embauche = '2006-01-01'::date)

Planning time: 0.055 ms

Execution time: 0.044 ms

(4 rows)

Dans ce deuxième essai, l’optimiseur estime ramener 17 lignes. En réalité, il n’en ramène que deux. L’estimation reste relativement précise étant donné le volume de données.

Dans le premier cas, l’optimiseur estime qu’il est moins coûteux de passer par une lecture séquentielle de la table plutôt qu’une lecture d’index. Dans le second cas, où le filtre est très sélectif, une lecture par index est plus appropriée.

VI-F-2. Statistiques : table et index▲

- Taille.

- Cardinalité.

-

Stocké dans pg_class :

- colonnes relpages et reltuples.

L’optimiseur a besoin de deux données statistiques pour une table ou un index : sa taille physique et le nombre de lignes portées par l’objet.

Ces deux données statistiques sont stockées dans la table pg_class. La taille de la table ou de l’index est exprimée en nombre de blocs de 8 ko et stockée dans la colonne relpages. La cardinalité de la table ou de l’index, c’est-à-dire le nombre de lignes, est stockée dans la colonne reltuples.

L’optimiseur utilisera ces deux informations pour apprécier la cardinalité de la table en fonction de sa volumétrie courante en calculant sa densité estimée, puis en utilisant cette densité multipliée par le nombre actuel de blocs de la table pour estimer le nombre réel de lignes de la table :

density = reltuples / relpages;

tuples = density * curpages;VI-F-3. Statistiques : monocolonne▲

- Nombre de valeurs distinctes.

- Nombre d’éléments qui n’ont pas de valeur NULL.

- Largeur d’une colonne.

-

Distribution des données :

- tableau des valeurs les plus fréquentes,

- histogramme de répartition des valeurs.

Au niveau d’une colonne, plusieurs données statistiques sont stockées :

- le nombre de valeurs distinctes ;

- le nombre d’éléments qui n’ont pas de valeur NULL ;

- la largeur moyenne des données portées par la colonne ;

- le facteur de corrélation entre l’ordre des données triées et la répartition physique des valeurs dans la table ;

- la distribution des données.

La distribution des données est représentée sous deux formes qui peuvent être complémentaires. Tout d’abord, un tableau de répartition permet de connaître les valeurs les plus fréquemment rencontrées et la fréquence d’apparition de ces valeurs. Un histogramme de distribution des valeurs rencontrées permet également de connaître la répartition des valeurs pour la colonne considérée.

VI-F-4. Stockage des statistiques monocolonne▲

-

Les informations statistiques vont dans la table pg_statistic :

- mais elle est difficile à comprendre.

- Mieux vaut utiliser la vue pg_stats.

- Une table vide n’a pas de statistiques.

Le stockage des statistiques se fait dans le catalogue système pg_statistic, mais les colonnes de cette table sont difficiles à interpréter. Il est préférable de passer par la vue pg_stats qui est plus facilement compréhensible par un être humain.

VI-F-5. Vue pg_stats▲

- Une ligne par colonne de chaque table et par index fonctionnel.

-

3 colonnes d’identification :

- schemaname, tablename, attname.

-

8 colonnes d’informations statistiques :

- inherited, null_frac, avg_width, n_distinct,

- most_common_vals, most_common_freqs, histogram_bounds,

- most_common_elems, most_common_elem_freqs, elem_count_histogram,

- correlation.

La vue pg_stats a été créée pour faciliter la compréhension des statistiques récupérées par la commande ANALYZE.

Elle est composée de trois colonnes qui permettent d’identifier la colonne :

- schemaname : nom du schéma (jointure possible avec pg_namespace).

- tablename : nom de la table (jointure possible avec pg_class, intéressant pour récupérer reltuples et relpages).

- attname : nom de la colonne (jointure possible avec pg_attribute, intéressant pour récupérer attstatstarget, valeur d’échantillon).

Suivent ensuite les colonnes de statistiques.

inherited

Si true, les statistiques incluent les valeurs de cette colonne dans les tables filles.

null_frac

Cette statistique correspond au pourcentage de valeurs NULL dans l’échantillon considéré. Elle est toujours calculée.

avg_width

Il s’agit de la largeur moyenne en octets des éléments de cette colonne. Elle est constante pour les colonnes dont le type est à taille fixe (integer, boolean, char, etc.). Dans le cas du type char(n), il s’agit du nombre de caractères saisissables + 1. Il est variable pour les autres (principalement text, varchar, bytea).

n_distinct

Si cette colonne contient un nombre positif, il s’agit du nombre de valeurs distinctes dans l’échantillon. Cela arrive uniquement quand le nombre de valeurs distinctes possibles semble fixe.

Si cette colonne contient un nombre négatif, il s’agit du nombre de valeurs distinctes dans l’échantillon divisé par le nombre de lignes. Cela survient uniquement quand le nombre de valeurs distinctes possibles semble variable. -1 indique donc que toutes les valeurs sont distinctes, -0,5 que chaque valeur apparaît deux fois.

Cette colonne peut être NULL si le type de données n’a pas d’opérateur =.

Il est possible de forcer cette colonne a une valeur constante en utilisant l’ordre ALTER TABLE nom_table ALTER COLUMN nom_colonne SET (parametre = valeur); où parametre vaut soit n_distinct (pour une table standard) soit n_distinct_inherited (pour une table comprenant des partitions). Pour les grosses tables contenant des valeurs distinctes, indiquer une grosse valeur ou la valeur -1 permet de favoriser l’utilisation de parcours d’index à la place de parcours de bitmap. C’est aussi utile pour des tables où les données ne sont pas réparties de façon homogène, et où la collecte de cette statistique est alors faussée.

most_common_vals

Cette colonne contient une liste triée des valeurs les plus communes. Elle peut être NULL si les valeurs semblent toujours aussi communes ou si le type de données n’a pas d’opérateur =.

most_common_freqs

Cette colonne contient une liste triée des fréquences pour les valeurs les plus communes. Cette fréquence est en fait le nombre d’occurrences de la valeur divisé par le nombre de lignes. Elle est NULL si most_common_vals est NULL.

histogram_bounds

PostgreSQL prend l’échantillon récupéré par ANALYZE. Il trie ces valeurs. Ces données triées sont partagées en x tranches égales (aussi appelées classes), où x dépend de la valeur du paramètre default_statistics_target ou de la configuration spécifique de la colonne. Il construit ensuite un tableau dont chaque valeur correspond à la valeur de début d’une tranche.

most_common_elems, most_common_elem_freqs, elem_count_histogram

Ces trois colonnes sont équivalentes aux trois précédentes, mais uniquement pour les données de type tableau.

correlation

Cette colonne est la corrélation statistique entre l’ordre physique et l’ordre logique des valeurs de la colonne. Si sa valeur est proche de -1 ou 1, un parcours d’index est privilégié. Si elle est proche de 0, un parcours séquentiel est mieux considéré.

Cette colonne peut être NULL si le type de données n’a pas d’opérateur <.

VI-F-6. Statistiques : multicolonnes▲

- Pas par défaut.

- CREATE STATISTICS.

-

Deux types de statistique :

- nombre de valeurs distinctes,

- dépendances fonctionnelles.

- À partir de la version 10.

Par défaut, la commande ANALYZE de PostgreSQL calcule des statistiques monocolonnes uniquement. Depuis la version 10, elle peut aussi calculer certaines statistiques multicolonnes.

Pour cela, il est nécessaire de créer un objet statistique avec l’ordre SQL CREATE STATISTICS. Cet objet indique les colonnes concernées ainsi que le type de statistique souhaité.

Actuellement, PostgreSQL supporte deux types de statistiques pour ces objets :

- ndistinct pour le nombre de valeurs distinctes sur ces colonnes ;

- dependencies pour les dépendances fonctionnelles.

Dans les deux cas, cela peut permettre d’améliorer fortement les estimations de nombre de lignes, ce qui ne peut qu’amener de meilleurs plans d’exécution.

Prenons un exemple. On peut voir sur ces deux requêtes que les statistiques sont à jour :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

22.

23.

24.

25.

EXPLAIN (ANALYZE)

SELECT * FROM services_big WHERE localisation='Paris';

QUERY PLAN

-------------------------------------------------------------------

Seq Scan on services_big (cost=0.00..786.05 rows=10013 width=28)

(actual time=0.019..4.773 rows=10001 loops=1)

Filter: ((localisation)::text = 'Paris'::text)

Rows Removed by Filter: 30003

Planning time: 0.863 ms

Execution time: 5.289 ms

(5 rows)

EXPLAIN (ANALYZE)

SELECT * FROM services_big where departement=75;

QUERY PLAN

-------------------------------------------------------------------

Seq Scan on services_big (cost=0.00..786.05 rows=10013 width=28)

(actual time=0.020..7.013 rows=10001 loops=1)

Filter: (departement = 75)

Rows Removed by Filter: 30003

Planning time: 0.219 ms

Execution time: 7.785 ms

(5 rows)

Cela fonctionne bien (c.-à-d. l’estimation du nombre de lignes est très proche de la réalité) dans le cas spécifique où le filtre se fait sur une seule colonne. Par contre, si le filtre se fait sur les deux colonnes, l’estimation diffère d’un facteur d’échelle :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

EXPLAIN (ANALYZE)

SELECT * FROM services_big where localisation='Paris' and departement=75;

QUERY PLAN

---------------------------------------------------------------------------

Seq Scan on services_big (cost=0.00..886.06 rows=2506 width=28)

(actual time=0.032..7.081 rows=10001 loops=1)

Filter: (((localisation)::text = 'Paris'::text) AND (departement = 75))

Rows Removed by Filter: 30003

Planning time: 0.257 ms

Execution time: 7.767 ms

(5 rows)

En fait, il y a une dépendance fonctionnelle entre ces deux colonnes, mais PostgreSQL ne le sait pas, car ses statistiques sont monocolonnes par défaut. Pour avoir des statistiques sur les deux colonnes, il faut créer un objet statistique pour ces deux colonnes :

2.

3.

CREATE STATISTICS stat_services_big (dependencies)

ON localisation, departement

FROM services_big;

Après création de l’objet statistique, il ne faut pas oublier de calculer les statistiques :

ANALYZE services_big;

Ceci fait, on peut de nouveau regarder les estimations :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

EXPLAIN (ANALYZE)

SELECT * FROM services_big where localisation='Paris' and departement=75;

QUERY PLAN

---------------------------------------------------------------------------

Seq Scan on services_big (cost=0.00..886.06 rows=10038 width=28)

(actual time=0.008..6.249 rows=10001 loops=1)

Filter: (((localisation)::text = 'Paris'::text) AND (departement = 75))

Rows Removed by Filter: 30003

Planning time: 0.121 ms

Execution time: 6.849 ms

(5 rows)

Cette fois, l’estimation est beaucoup plus proche de la réalité.

Maintenant, prenons le cas d’un regroupement :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

EXPLAIN (ANALYZE)

SELECT localisation, COUNT(*) FROM services_big GROUP BY localisation;

QUERY PLAN

------------------------------------------------------------------------

HashAggregate (cost=886.06..886.10 rows=4 width=14)

(actual time=12.925..12.926 rows=4 loops=1)

Group Key: localisation

-> Seq Scan on services_big (cost=0.00..686.04 rows=40004 width=6)

(actual time=0.010..2.779 rows=40004 loops=1)

Planning time: 0.162 ms

Execution time: 13.033 ms

(5 rows)

L’estimation du nombre de lignes pour un regroupement sur une colonne est très bonne. Par contre, sur deux colonnes :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

EXPLAIN (ANALYZE)

SELECT localisation, departement, COUNT(*)

FROM services_big

GROUP BY localisation, departement;

QUERY PLAN

-------------------------------------------------------------------------

HashAggregate (cost=986.07..986.23 rows=16 width=18)

(actual time=15.830..15.831 rows=4 loops=1)

Group Key: localisation, departement

-> Seq Scan on services_big (cost=0.00..686.04 rows=40004 width=10)

(actual time=0.005..3.094 rows=40004 loops=1)

Planning time: 0.102 ms

Execution time: 15.860 ms

(5 rows)

Là-aussi, on constate un facteur d’échelle important entre l’estimation et la réalité. Et là-aussi, c’est un cas où un objet statistique peut fortement aider :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

DROP STATISTICS stat_services_big;

CREATE STATISTICS stat_services_big (dependencies,ndistinct)

ON localisation, departement

FROM services_big;

ANALYZE services_big ;

EXPLAIN (ANALYZE)

SELECT localisation, departement, COUNT(*)

FROM services_big

GROUP BY localisation, departement;

QUERY PLAN

-------------------------------------------------------------------------

HashAggregate (cost=986.07..986.11 rows=4 width=18)

(actual time=14.351..14.352 rows=4 loops=1)

Group Key: localisation, departement

-> Seq Scan on services_big (cost=0.00..686.04 rows=40004 width=10)

(actual time=0.013..2.786 rows=40004 loops=1)

Planning time: 0.305 ms

Execution time: 14.413 ms

(5 rows)

L’estimation est bien meilleure grâce aux statistiques spécifiques aux deux colonnes.

VI-F-7. Catalogue pg_statistic_ext▲

- Une ligne par objet statistique.

-

Quatre colonnes d’identification :

- stxrelid, stxname, stxnamespace, stxkeys.

-

Une colonne pour connaître le type de statistiques géré :

- stxkind.

-

Deux colonnes d’informations statistiques :

- stxndistinct.

- stxdependencies.

stxname est le nom de l’objet statistique, et stxnamespace l’OID de son schéma.

stxrelid précise l’OID de la table concernée par cette statistique. stxkeys est un tableau d’entiers correspondant aux numéros des colonnes.

stxkind peut avoir une ou plusieurs valeurs parmi d pour le nombre de valeurs distinctes et f pour les dépendances fonctionnelles.

Voici un exemple sur l’objet statistique créé précédemment :

2.

3.

4.

5.

6.

7.

8.

9.

10.

postgres=# select * from pg_statistic_ext;

-[ RECORD 1 ]---+-----------------------------------------

stxrelid | 16394

stxname | stat_services_big

stxnamespace | 2200

stxowner | 10

stxkeys | 3 4

stxkind | {d,f}

stxndistinct | {"3, 4": 4}

stxdependencies | {"3 => 4": 1.000000, "4 => 3": 1.000000}

VI-F-8. ANALYZE▲

- Ordre SQL de calcul de statistiques :

ANALYZE[ VERBOSE ][ table [ ( colonne [, ...])] ] - Sans argument : base entière.

- Avec argument : la table complète ou certaines colonnes seulement.

- Prend un échantillon de chaque table.

- Et calcule des statistiques sur cet échantillon.

- Si table vide, conservation des anciennes statistiques.

ANALYZE est l’ordre SQL permettant de mettre à jour les statistiques sur les données. Sans argument, l’analyse se fait sur la base complète. Si un argument est donné, il doit correspondre au nom de la table à analyser. Il est même possible d’indiquer les colonnes à traiter.

En fait, cette instruction va exécuter un calcul d’un certain nombre de statistiques. Elle ne va pas lire la table entière, mais seulement un échantillon. Sur cet échantillon, chaque colonne sera traitée pour récupérer quelques informations comme le pourcentage de valeurs NULL, les valeurs les plus fréquentes et leur fréquence, sans parler d’un histogramme des valeurs. Toutes ces informations sont stockées dans un catalogue système nommé pg_statistics.

Dans le cas d’une table vide, les anciennes statistiques sont conservées. S’il s’agit d’une nouvelle table, les statistiques sont initialement vides. La table n’est jamais considérée vide par l’optimiseur, qui utilise alors des valeurs par défaut.

VI-F-9. Fréquence d’analyse▲

- Dépend principalement de la fréquence des requêtes DML.

-

Cron :

- avec psql,

- avec vacuumdb et son option --analyze-only.

-

Autovacuum fait du ANALYZE mais… :

- pas sur les tables temporaires,

- pas assez rapidement dans certains cas.

Les statistiques doivent être mises à jour fréquemment. La fréquence exacte dépend surtout de la fréquence des requêtes d’insertion/modification/ suppression des lignes des tables. Néanmoins, un ANALYZE tous les jours semble un minimum, sauf cas spécifique.

L’exécution périodique peut se faire avec cron (ou les tâches planifiées sous Windows). Il n’existe pas d’outils PostgreSQL pour lancer un seul ANALYZE . L’outil vacuumdb se voit doté d’une option --analyze-only pour combler ce manque. Avant, il était nécessaire de passer par psql et son option -c qui permet de préciser la requête à exécuter. En voici un exemple :

psql -c "ANALYZE" b1

Cet exemple exécute la commande ANALYZE sur la base b1 locale.

Le démon autovacuum fait aussi des ANALYZE. La fréquence dépend de sa configuration. Cependant, il faut connaître deux particularités de cet outil :

- Ce démon a sa propre connexion à la base. Il ne peut donc pas voir les tables temporaires appartenant aux autres sessions. Il ne sera donc pas capable de mettre à jour leurs statistiques.

- Après une insertion ou une mise à jour massive, autovacuum ne va pas forcément lancer un ANALYZE immédiat. En effet, autovacuum ne cherche les tables à traiter que toutes les minutes (par défaut). Si, après la mise à jour massive, une requête est immédiatement exécutée, il y a de fortes chances qu’elle s’exécute avec des statistiques obsolètes. Il est préférable dans ce cas de lancer un ANALYZE manuel sur la ou les tables ayant subi l’insertion ou la mise à jour massive.

VI-F-10. Échantillon statistique▲

-

Se configure dans postgresql.conf :

- default_statistics_target = 100.

- Configurable par colonne :

ALTER TABLE nom ALTER [ COLUMN ] colonne

SET STATISTICS valeur;-

Par défaut, récupère 30 000 lignes au hasard :

- 300 * default_statistics_target.

- Va conserver les cent valeurs les plus fréquentes avec leur fréquence.

Par défaut, un ANALYZE récupère 30 000 lignes d’une table. Les statistiques générées à partir de cet échantillon sont bonnes si la table ne contient pas des millions de lignes. Si c’est le cas, il faudra augmenter la taille de l’échantillon. Pour cela, il faut augmenter la valeur du paramètre default_statistics_target. Ce dernier vaut 100 par défaut. La taille de l’échantillon est de 300 x default_statistics_target. Augmenter ce paramètre va avoir plusieurs répercussions. Les statistiques seront plus précises grâce à un échantillon plus important. Mais du coup, les statistiques seront plus longues à calculer, prendront plus de place sur le disque, et demanderont plus de travail au planificateur pour générer le plan optimal. Augmenter cette valeur n’a donc pas que des avantages.

Du coup, les développeurs de PostgreSQL ont fait en sorte qu’il soit possible de le configurer colonne par colonne avec l’instruction suivante :

ALTER TABLE nom_table ALTER nom_colonne SET STATISTICS valeur;

VI-G. Qu’est-ce qu’un plan d’exécution ?▲

- Représente les différentes opérations pour répondre à la requête.

- Sous forme arborescente.

- Composé des nœuds d’exécution.

- Plusieurs opérations simples mises bout à bout.

VI-G-1. Nœud d’exécution▲

-

Nœud :

- opération simple : lectures, jointures, tris, etc.,

- unité de traitement,

- produit et consomme des données.

-

Enchaînement des opérations :

- chaque nœud produit les données consommées par le nœud parent,

- le nœud final retourne les données à l’utilisateur.

Les nœuds correspondent à des unités de traitement qui réalisent des opérations simples sur un ou deux ensembles de données : lecture d’une table, jointures entre deux tables, tri d’un ensemble, etc. Si le plan d’exécution était une recette, chaque nœud serait une étape de la recette.

Les nœuds peuvent produire et consommer des données.

VI-G-2. Récupérer un plan d’exécution▲

-

Commande EXPLAIN :

- suivi de la requête complète.

- Uniquement le plan finalement retenu.

Pour récupérer le plan d’exécution d’une requête, il suffit d’utiliser la commande EXPLAIN. Cette commande est suivie de la requête pour laquelle on souhaite le plan d’exécution.

Seul le plan sélectionné est affichable. Les plans ignorés du fait de leur coût trop important ne sont pas récupérables. Ceci est dû au fait que les plans en question peuvent être abandonnés avant d’avoir été totalement développés si leur coût partiel est déjà supérieur à celui de plans déjà considérés.

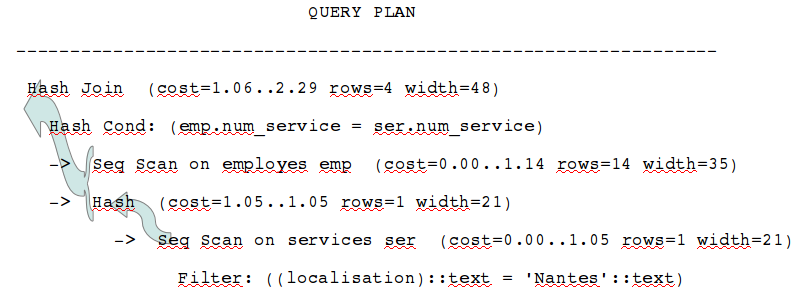

VI-G-3. Lecture d’un plan▲

Un plan d’exécution est lu en partant du nœud se trouvant le plus à droite et en remontant jusqu’au nœud final. Quand le plan contient plusieurs nœuds, le premier nœud exécuté est celui qui se trouve le plus à droite. Celui qui est le plus à gauche (la première ligne) est le dernier nœud exécuté. Tous les nœuds sont exécutés simultanément, et traitent les données dès qu’elles sont transmises par le nœud parent (le ou les nœuds juste en dessous, à droite).

Chaque nœud montre les coûts estimés dans le premier groupe de parenthèses :

- cost est un couple de deux coûts ;

- la première valeur correspond au coût pour récupérer la première ligne (souvent nul dans le cas d’un parcours séquentiel) ;

- la deuxième valeur correspond au coût pour récupérer toutes les lignes (cette valeur dépend essentiellement de la taille de la table lue, mais aussi de l’opération de filtre ici présente) ;

- rows correspond au nombre de lignes que le planificateur pense récupérer à la sortie de ce nœud ;

- width est la largeur en octets de la ligne.

Cet exemple simple permet de voir le travail de l’optimiseur :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

SET enable_nestloop TO off;

EXPLAIN

SELECT matricule, nom, prenom, nom_service, fonction, localisation

FROM employes emp

JOIN services ser ON (emp.num_service = ser.num_service)

WHERE ser.localisation = 'Nantes';

QUERY PLAN

-------------------------------------------------------------------------

Hash Join (cost=1.06..2.34 rows=4 width=48)

Hash Cond: (emp.num_service = ser.num_service)

-> Seq Scan on employes emp (cost=0.00..1.14 rows=14 width=35)

-> Hash (cost=1.05..1.05 rows=1 width=21)

-> Seq Scan on services ser (cost=0.00..1.05 rows=1 width=21)

Filter: ((localisation)::text = 'Nantes'::text)

(6 rows)

RESET enable_nestloop;

Ce plan débute par la lecture de la table services. L’optimiseur estime que cette lecture ramènera une seule ligne (rows=1), que cette ligne occupera 21 octets en mémoire (width=21). Il s’agit de la sélectivité du filtre WHERE localisation = 'Nantes'. Le coût de départ de cette lecture est de 0 (cost=0.00). Le coût total de cette lecture est de 1.05, qui correspond à la lecture séquentielle d’un seul bloc (donc seq_page_cost) et à la manipulation des 4 lignes de la table services (donc 4 * cpu_tuple_cost + 4 * cpu_operator_cost). Le résultat de cette lecture est ensuite haché par le nœud Hash, qui précède la jointure de type Hash Join.

La jointure peut maintenant commencer, avec le nœud Hash Join. Il est particulier, car il prend deux entrées : la donnée hachée initialement, et les données issues de la lecture d’une seconde table (peu importe le type d’accès). Le nœud a un coût de démarrage de 1.06, soit le coût du hachage additionné au coût de manipulation du tuple de départ. Il s’agit du coût de production du premier tuple de résultat. Le coût total de production du résultat est de 2.34. La jointure par hachage démarre réellement lorsque la lecture de la table employes commence. Cette lecture remontera 14 lignes, sans application de filtre. La totalité de la table est donc remontée et elle est très petite donc tient sur un seul bloc de 8 ko. Le coût d’accès total est donc facilement déduit à partir de cette information. À partir des sélectivités précédentes, l’optimiseur estime que la jointure ramènera 4 lignes au total.

VI-G-4. Options de l’EXPLAIN▲

-

Des options supplémentaires :

- ANALYZE: exécution (danger !),

- BUFFERS: blocs read/hit/written, shared/local/temp,

- COSTS: par défaut,

- TIMING: par défaut,

- VERBOSE: colonnes considérées,

- SUMMARY: temps de planification,

- FORMAT : sortie en XML, JSON, YAML.

-

Donnant des informations supplémentaires très utiles :

- ou permettant de cacher des informations inutiles.

Au fil des versions, EXPLAIN a gagné en options. L’une d’entre elles permet de sélectionner le format en sortie. Toutes les autres permettent d’obtenir des informations supplémentaires.

Option ANALYZE

Le but de cette option est d’obtenir les informations sur l’exécution réelle de la requête.

Avec cette option, la requête est réellement exécutée. Attention aux INSERT/ UPDATE/DELETE. Pensez à les englober dans une transaction que vous annulerez après coup.

Voici un exemple utilisant cette option :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

EXPLAIN (ANALYZE) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------

Seq Scan on employes (cost=0.00..1.18 rows=3 width=43)

(actual time=0.004..0.005 rows=3 loops=1)

Filter: (matricule < 100)

Rows Removed by Filter: 11

Planning time: 0.027 ms

Execution time: 0.013 ms

(5 rows)

Quatre nouvelles informations apparaissent, toutes liées à l’exécution réelle de la requête :

- actual time ;

- la première valeur correspond à la durée en millisecondes pour récupérer la première ligne ;

- la deuxième valeur est la durée en millisecondes pour récupérer toutes les lignes ;

- rows est le nombre de lignes réellement récupérées ;

- loops est le nombre d’exécutions de ce nœud.

Multiplier la durée par le nombre de boucles pour obtenir la durée réelle d’exécution du nœud.

L’intérêt de cette option est donc de trouver l’opération qui prend du temps dans l’exécution de la requête, mais aussi de voir les différences entre les estimations et la réalité (notamment au niveau du nombre de lignes).

Option BUFFERS

Cette option n’est utilisable qu’avec l’option ANALYZE. Elle est désactivée par défaut.

Elle indique le nombre de blocs impactés par chaque nœud du plan d’exécution, en lecture comme en écriture.

Voici un exemple de son utilisation :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

EXPLAIN (ANALYZE,BUFFERS) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------

Seq Scan on employes (cost=0.00..1.18 rows=3 width=43)

(actual time=0.002..0.004 rows=3 loops=1)

Filter: (matricule < 100)

Rows Removed by Filter: 11

Buffers: shared hit=1

Planning time: 0.024 ms

Execution time: 0.011 ms

(6 rows)

La nouvelle ligne est la ligne Buffers. Elle peut contenir un grand nombre d’informations :

|

Informations |

Type d’objet concerné |

Explications |

|---|---|---|

|

Shared hit |

Table ou index permanent |

Lecture d’un bloc dans le cache |

|

Shared read |

Table ou index permanent |

Lecture d’un bloc hors du cache |

|

Shared written |

Table ou index permanent |

Écriture d’un bloc |

|

Local hit |

Table ou index temporaire |

Lecture d’un bloc dans le cache |

|

Local read |

Table ou index temporaire |

Lecture d’un bloc hors du cache |

|

Local written |

Table ou index temporaire |

Écriture d’un bloc |

|

Temp read |

Tris et hachages |

Lecture d’un bloc |

|

Temp written |

Tris et hachages |

Écriture d’un bloc |

Option COSTS

Une fois activée, l’option COSTS indique les estimations du planificateur. Cette option est activée par défaut.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

EXPLAIN (COSTS OFF) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

-----------------------------

Seq Scan on employes

Filter: (matricule < 100)

(2 rows)

EXPLAIN (COSTS ON) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------

Seq Scan on employes (cost=0.00..1.18 rows=3 width=43)

Filter: (matricule < 100)

(2 rows)

Option TIMING

Cette option n’est utilisable qu’avec l’option ANALYZE. Elle ajoute les informations sur les durées en millisecondes. Elle est activée par défaut. Sa désactivation peut être utile sur certains systèmes où le chronométrage prend beaucoup de temps et allonge inutilement la durée d’exécution de la requête.

Voici un exemple de son utilisation :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

22.

23.

EXPLAIN (ANALYZE, TIMING ON) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------

Seq Scan on employes (cost=0.00..1.18 rows=3 width=43)

(actual time=0.003..0.004 rows=3 loops=1)

Filter: (matricule < 100)

Rows Removed by Filter: 11

Planning time: 0.022 ms

Execution time: 0.010 ms

(5 rows)

EXPLAIN (ANALYZE, TIMING OFF) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------

Seq Scan on employes (cost=0.00..1.18 rows=3 width=43)

(actual rows=3 loops=1)

Filter: (matricule < 100)

Rows Removed by Filter: 11

Planning time: 0.025 ms

Execution time: 0.010 ms

(5 rows)

Option VERBOSE

L’option VERBOSE permet d’afficher des informations supplémentaires comme la liste des colonnes en sortie, le nom de la table qualifié du nom du schéma, le nom de la fonction qualifié du nom du schéma, le nom du trigger, etc. Elle est désactivée par défaut.

2.

3.

4.

5.

6.

7.

8.

9.

EXPLAIN (VERBOSE) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

---------------------------------------------------------------------

Seq Scan on public.employes (cost=0.00..1.18 rows=3 width=43)

Output: matricule, nom, prenom, fonction, manager, date_embauche,

num_service

Filter: (employes.matricule < 100)

(3 rows)

On voit dans cet exemple que le nom du schéma est ajouté au nom de la table. La nouvelle section Output indique la liste des colonnes de l’ensemble de données en sortie du nœud.

Option SUMMARY

Cette option apparaît en version 10. Elle permet d’afficher ou non le résumé final indiquant la durée de la planification et de l’exécution. Un EXPLAIN simple n’affiche pas le résumé par défaut. Par contre, un EXPLAIN ANALYZE l’affiche par défaut.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

22.

23.

24.

25.

26.

27.

28.

29.

30.

31.

32.

EXPLAIN SELECT * FROM employes;

QUERY PLAN

----------------------------------------------------------

Seq Scan on employes (cost=0.00..1.14 rows=14 width=43)

(1 row)

EXPLAIN (SUMMARY ON) SELECT * FROM employes;

QUERY PLAN

----------------------------------------------------------

Seq Scan on employes (cost=0.00..1.14 rows=14 width=43)

Planning time: 0.014 ms

(2 rows)

EXPLAIN (ANALYZE) SELECT * FROM employes;

QUERY PLAN

----------------------------------------------------------

Seq Scan on employes (cost=0.00..1.14 rows=14 width=43)

(actual time=0.002..0.003 rows=14 loops=1)

Planning time: 0.013 ms

Execution time: 0.009 ms

(3 rows)

EXPLAIN (ANALYZE, SUMMARY OFF) SELECT * FROM employes;

QUERY PLAN

----------------------------------------------------------

Seq Scan on employes (cost=0.00..1.14 rows=14 width=43)

(actual time=0.002..0.003 rows=14 loops=1)

(1 row)

Option FORMAT

L’option FORMAT permet de préciser le format du texte en sortie. Par défaut, il s’agit du texte habituel, mais il est possible de choisir un format balisé parmi XML, JSON et YAML. Voici ce que donne la commande EXPLAIN avec le format XML :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

EXPLAIN (FORMAT XML) SELECT * FROM employes WHERE matricule < 100;

QUERY PLAN

----------------------------------------------------------

<explain xmlns="http://www.postgresql.org/2009/explain">+

<Query> +

<Plan> +

<Node-Type>Seq Scan</Node-Type> +

<Parallel-Aware>false</Parallel-Aware> +

<Relation-Name>employes</Relation-Name> +

<Alias>employes</Alias> +

<Startup-Cost>0.00</Startup-Cost> +

<Total-Cost>1.18</Total-Cost> +

<Plan-Rows>3</Plan-Rows> +

<Plan-Width>43</Plan-Width> +

<Filter>(matricule < 100)</Filter> +

</Plan> +

</Query> +

</explain>

(1 row)

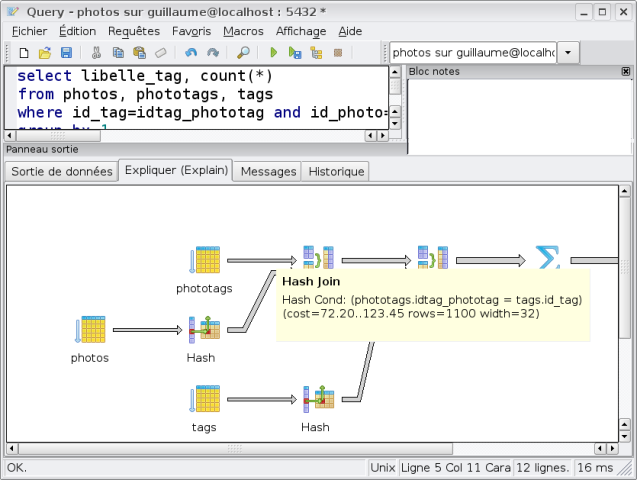

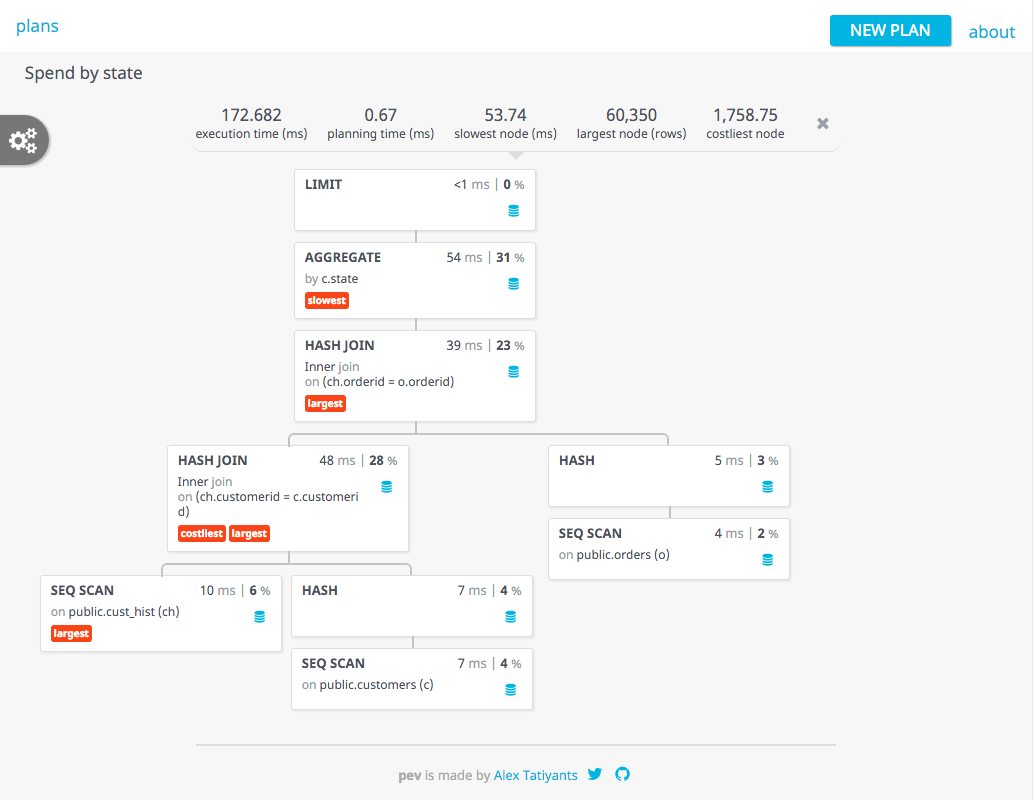

Les formats semi-structurés sont utilisés principalement par des outils pour qu’ils retrouvent facilement les informations. Par exemple, pgAdmin IV utilise le format JSON pour afficher graphiquement un plan d’exécution.

VI-G-5. Détecter les problèmes▲

- Différence importante entre l’estimation du nombre de lignes et la réalité.

-

Boucles :

- appels très nombreux dans une boucle (Nested loop),

- opérations lentes sur lesquelles PostgreSQL boucle.

- Temps d’exécution important sur une opération.

- Opérations utilisant beaucoup de blocs (option BUFFERS).

Lorsqu’une requête s’exécute lentement, cela peut être un problème dans le plan. La sortie de EXPLAIN peut apporter quelques informations qu’il faut savoir décoder. Une différence importante entre le nombre estimé de lignes et le nombre réel de lignes laisse un doute sur les statistiques présentes. Soit elles n’ont pas été réactualisées récemment, soit l’échantillon n’est pas suffisamment important pour que les statistiques donnent une vue proche du réel contenu de la table.

L’option BUFFERS d’EXPLAIN permet également de mettre en valeur les opérations d’entrées/sorties lourdes. Cette option affiche notamment le nombre de blocs lus en/hors du cache de PostgreSQL. Sachant qu’un bloc fait généralement 8 ko, il est aisé de déterminer le volume de données manipulé par une requête.

VI-G-6. Statistiques et coûts▲

-

Détermine à partir des statistiques :

- cardinalité des prédicats,

- cardinalité des jointures.

-

Coût d’accès déterminé selon :

- des cardinalités,

- volumétrie des tables.

Afin de comparer les différents plans d’exécution possibles pour une requête et choisir le meilleur, l’optimiseur a besoin d’estimer un coût pour chaque nœud du plan.

L’estimation la plus cruciale est celle liée aux nœuds de parcours de données, car c’est d’eux que découlera la suite du plan. Pour estimer le coût de ces nœuds, l’optimiseur s’appuie sur les informations statistiques collectées, ainsi que sur la valeur de paramètres de configuration.

Les deux notions principales de ce calcul sont la cardinalité (nombre de lignes estimées en sortie d’un nœud) et la sélectivité (fraction des lignes conservées après l’application d’un filtre).

Voici ci-dessous un exemple de calcul de cardinalité et de détermination du coût associé.

Calcul de cardinalité

Pour chaque prédicat et chaque jointure, PostgreSQL va calculer sa sélectivité et sa cardinalité. Pour un prédicat, cela permet de déterminer le nombre de lignes retournées par le prédicat par rapport au nombre total de lignes de la table. Pour une jointure, cela permet de déterminer le nombre de lignes retournées par la jointure entre deux tables.

L’optimiseur dispose de plusieurs façons de calculer la cardinalité d’un filtre ou d’une jointure selon que la valeur recherchée est une valeur unique, que la valeur se trouve dans le tableau des valeurs les plus fréquentes ou dans l’histogramme. L’exemple ci-dessous montre comment calculer la cardinalité d’un filtre simple sur une table employes de 14 lignes. La valeur recherchée se trouve dans le tableau des valeurs les plus fréquentes, la cardinalité peut être calculée directement. Si ce n’était pas le cas, il aurait fallu passer par l’histogramme des valeurs pour calculer d’abord la sélectivité du filtre pour en déduire ensuite la cardinalité.

La requête suivante permet de récupérer la fréquence d’apparition de la valeur recherchée dans le prédicat WHERE num_service = 1 pour notre table d’exemple employes :

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

SELECT tablename, attname, value, freq

FROM (SELECT tablename, attname, mcv.value, mcv.freq FROM pg_stats,

LATERAL ROWS FROM (unnest(most_common_vals::text::int[]),

unnest(most_common_freqs)) AS mcv(value, freq)

WHERE tablename = 'employes'

AND attname = 'num_service') get_mcv

WHERE value = 1;

tablename | attname | value | freq

-----------+-------------+-------+----------

employes | num_service | 1 | 0.142857

(1 row)

L’optimiseur calcule la cardinalité du prédicat WHERE num_service = 1 en multipliant cette fréquence de la valeur recherchée avec le nombre total de lignes de la table :

2.

3.

4.

5.

6.

7.

8.